Wissenschaft und Kritik - Wissenschaft und Technik

25.12.2001

Einige ganz persönliche Erinnnerungen und Gedanken

Auf dieser Seite erscheinen Zitate aus dem Jahr 1957. Es gibt Aussagen, die sind viel älter, aber das Jahr

1957 ist immerhin ein Jahr, an das ich mich persönlich erinnern kann. Es begann das so genannte Internationale Geophysikalische Jahr (1.7.57 bis 31.12.58). Auf dieser Seite erscheinen Zitate aus dem Jahr 1957. Es gibt Aussagen, die sind viel älter, aber das Jahr

1957 ist immerhin ein Jahr, an das ich mich persönlich erinnern kann. Es begann das so genannte Internationale Geophysikalische Jahr (1.7.57 bis 31.12.58).

Zitat Bertelsmann Universallexikon, Stichwort Internationales Geophysikalische Jahr:

Abkürzung IGJ, internationale Forschungsunternehmung zur gemeinsamen Beobachtung von Erscheinungen aus den Bereichen des Wetters, des Erdmagnetismus, von Polarlicht und

Nachthimmelslicht, Ionosphäre, Sonnenaktivität, kosmischer Strahlung, Gletscherbewegung, ozeanischer Zirkulation, Erdbeben, Schwerkraft und radioaktiver Strahlung, vom 1. 7. 1957—31. 12.

1958 veranstaltet vom Internationalen Rat der Wissenschaftlichen Unionen (International Council of Scientific Unions); Schwerpunkte:

Antarktisforschung, Raketen- und Satellitenmessungen, Meeresforschung. Die Beobachtungsstationen befanden sich längs der 3 IGJ

-Meridiane 75° w. L., 10° und 40° ö. L.; ein 2. Gitter von 3 Zonen umspannte die Erde am nördlichen Polarkreis, am Äquator und über Antarktika. Insgesamt beteiligten sich 54 Nationen.

Das Jahr 2002 nun ist das Jahr der Geowisssenschaften, im Rahmen der Initiative “Wissenschaft im Dialog” des

Bundesministeriums für Bildung und Forschung. Herausragendes Ereignis damals war der erste Sputnik, der am 4. Oktober 1957 auf die Umlaufbahn geschickt wurde. Bereits ein Monat später,

am 3. November des gleichen Jahres, begann Sputnik 2 seine Runden zu drehen. An Bord befand sich als erste “offizielle

Weltraumreisende” die Hündin Laika. am 3. November des gleichen Jahres, begann Sputnik 2 seine Runden zu drehen. An Bord befand sich als erste “offizielle

Weltraumreisende” die Hündin Laika.

Das Zeitalter der Raumfahrt begann! Nun ja, der kugelförmige erste Satellit hatte nur einen Durchmesser von 58

Zentimeter und wog schlappe 83 Kilogramm. Ziemlich mickrig und ernüchternd erschien mir das. Aber der zweite

“Begleiter” beherbergte bereits ein Versuchstier und brachte immerhin etwas mehr als 500 Kilogramm auf die

Waage. Aber Sputnik 3, am 15. Mai 1958 in die Umlaufbahn gebracht, stieß mit über 1300 Kilogramm in hanfestere Dimensionen vor.

Immerhin profitieren wir heutzutage in Gestalt der Nachrichtensatelliten, die uns gar viele Fernsehprogramme bescheren, auch von jenen Anfängen.

Diese mögliche künftige Nutzanwendung war auch damals bereits im Gespräch. Dass es - viel später - auch einmal Navigationssysteme geben

würde, war grundsätzlich nicht vorhersehbar, da hierzu technische Voraussetzungen geschaffen werden mussten, von denen man damals noch nicht einmal träumen konnte. Nachtrag 2018

Und das Zeitalter der friedlichen Anwendung der Kernenergie war gleichfalls angebrochen. Das bedurfte keiner Frage. Die Frage war nur, wann sämtliche Energie aus Atomenergie gewonnen werden würde. Darüber,

dass dies in absehbarer Zeit geschehen würde, herrschte wohl allseits Einigkeit.

Heute sind wir klüger - die Vergangenheit betreffend.

Doch die Klugheit hat wohl Grenzen - geht es um die Gegenwart und die Zukunft.

08.04.2001

Das aktuelle Thema ist der Ausstieg aus der Kernenergie.

Vor 40 bis 50 Jahren gab es andere Schwerpunkte und auch gewisse Fehleinschätzungen. Da wurden - wenige Jahre nach dem Zweiten Weltkrieg -

Pläne bekannt zur atomaren Aufrüstung auch der Bundeswehr. Im

Göttinger Manifest der 18 Atomwissenschaftler vom 12. April 1957 (als Göttinger Erklärung

populär geworden) warnten führende Physiker vor den Gefahren der atomaren Bewaffnung und den Gefahren des atomaren

Wettrüstens überhaupt, wenngleich "das Gleichgewicht der Kräfte" immerhin als notwendiges Übel betrachtet wurde, aber nicht auf Dauer angestrebt werden sollte. Dass 32 Jahre später der

Kalte Krieg beendet sein würde, konnte niemand ahnen. Und dass damals die Gefahr eines

Atomkrieges nicht nur in der Phantasie einiger unverbesserlicher Pessimisten bestand, sondern ziemlich real war, dürfte heutzutage allgemein bekannt sein.

Einer der Unterzeichner der Göttinger Erklärung war C. F. v. Weizsäcker (1912 - 2007). Grund genug, sich mit der Problemstrecke der

Kernenergie für friedliche Zwecke zu befassen. Im Buch Atomenergie und Atomzeitalter (1. Auflage 1957 und 2. Auflage 1958) sind zwölf Vorlesungen v. Weizsäcker

s abgedruckt, die auch aus heutiger Sicht interessant zu lesen sind. So sehr man auch schon damals gegen die atomare

Rüstung war, so gab es an einer Tatsache nicht den geringsten Zweifel: Die friedliche Nutzung der Kernenergie wird nun unwiderruflich kommen und

einen wesentlichen Beitrag zum Gesamtenergieaufkommen leisten. Hier ist es durchaus interessant und lehrreich, einmal nachzulesen, wie man vor

mehr als vier Jahrzehnten die Gefahren der friedlichen Nutzung der Kernenergie (hier zunächst die der Kernspaltung) einschätzte. Und die

Einschätzung eines C.F.v.Weizsäcker dürfte durchaus repräsentativ für die Haltung der Wissenschaftler der damaligen Zeit sein:

Die Atombombenversuche einzustellen, ist eine heute sehr weitverbreitete Forderung, und wir müssen sehr hoffen, daß sie erfüllt werden

wird. Die Weiterentwicklung der friedlichen Atomtechnik einzustellen ist hingegen eine Forderung, die nur wenige erheben und die so gut

wie keine Aussicht auf Erfüllung hat. Deshalb ist es für uns das Wichtigste, uns klarzuwerden, was für Folgen diese Technik , die zu

unserem zukünftigen Schicksal wohl mit Gewißheit gehören wird, für unser Leben haben kann.

Seit Harrisburg (USA, Reaktorunfall 1979), und - spätestens - seit Tschernobyl (UdSSR, 1986) hat sich die Einstellung einer Vielzahl von

Menschen zur friedlichen Nutzung der Kernenergie doch ein wenig gewandelt. Und bereits 1957(!) sorgte ein Brand in einem der Reaktoren in Windscale (GB) für die Freisetzung großer Mengen radioaktiven Materials. Wer glaubt, dass es nun endlich genug ist, der sei an

Tokaimura (Atomunfall in einer Wiederaufbereitungsanlage in Japan, 30. September 1999) erinnert.

Doch weiter im Text v. Weizsäckers:

Ich glaube nun, man wird jedenfalls trotz der großen Ungewißheiten, die über das genaue Ausmaß dieser Wirkungen heute noch bestehen,

sagen zu dürfen, daß diese Wirkungen nicht größer sein werden als andere Rückwirkungen der neuzeitlichen Technik auf das menschliche

Leben. Es liegt mir ganz fern, diese Wirkungen bagatellisieren zu wollen, denn ich habe das Gefühl, daß wir an vielen Stellen uns der

gefährlichen Rückwirkung der Technik auf das Leben bei weitem nicht genug bewußt sind. Aber auf der anderen Seite wäre es ganz falsch,

eine panische Angst gerade vor den Wirkungen dieser Radioaktivität zu verbreiten, so als ob sie das Ausmaß der bisherigen Rückwirkungen der Technik auf unser Leben noch einmal überstiegen.

...Es ist aber auf der anderen Seite nicht zu leugnen, daß die Menschheit offenbar bereit ist, für den Straßenverkehr, den sie nicht missen will, solche Todesopfer in Kauf zu nehmen.

Dieser Vergleich hinkt ein wenig. Wie alle Vergleiche eben ich gerade leichtfüßig daherhüpfen. Irgend etwas stimmt an dieser Argumentation nicht,

glaube ich. Um es vereinfacht auszudrücken: Ich habe grundsätzlich - ganz persönlich - die Freiheit, mich dem Straßenverkehr weitgehend zu

verweigern, indem ich nicht mit dem Auto fahre und als Fußgänger mich ganz besonders vorsichtig verhalte. Und außerdem kann ich mich mit der

Illusion beruhigen, dass ich ganz gewiss nie in einen schweren Verkehrsunfall verwickelt sein werde. Tatsache jedoch ist: Die Gefahren des

Straßenverkehrs sind sichtbar, überschaubar - und das klingt vielleicht zynisch, ist aber nicht so gemeint - abgrenzbar. Und ein weiteres Problem:

Die Mehrzahl der Unfälle sind auf menschliches Versagen, insbesondere auch auf die Selbstüberschätzung vieler (oft noch junger)

Verkehrsteilnehmer zurückzuführen. Nun sind auch die anderen Verkehrsmittel, wie Bahn und Flugzeug auch nicht gänzlich risikofrei. Aber hier

taucht zudem das Problem auf, dass der (passive) Passagier selbst keinen Einfluss mehr hat auf das Geschehen rings um ihn. Er vertraut vollends auf

das geschulte und immer einsatzfähige Personal. Doch auch hier gilt: Die Folgen eines Unfalls sind immer noch abgrenzbar. (vgl. Der

versehentliche Mäusetod)

All dies gilt für die Kerntechnik nicht mehr. Die Auswirkungen möglicher Unfälle mit dem Freisetzen radioaktiven Materials ist eben weder vom

Einzelnen - durch "Wohlverhalten" (z.B. im Straßenverkehr) - beeinflussbar, noch überhaupt abgrenzbar. Und die Folgen von Strahlenschäden überbrücken Menschengenerationen!

Doch weiter bei C.F.v.Weizsäcker:

Nun möchte ich annehmen, daß die Wirkungen der radioaktiven Strahlen, die durch die Reaktoren in Luft und Wasser kommen, nicht erheblich größer sein werden als diese Wirkungen des Straßenverkehrs.

Wie schon bemerkt, hinkt dieser Vergleich recht erheblich. Denn hier wird, bezogen auf den Straßenverkehr, die Ausnahme (der Unfall eben) als

Maßstab herangezogen und bei der friedlichen Nutzung der Kernenergie der Normalzustand (kein Unfall) als Vergleich genommen. Auch die notwendigen Sicherheitsvorkehrungen werden erwähnt.

Und so sind - dies bezieht sich auf den gegenwärtigen Zustand - die deutschen Kernkraftwerke (angeblich) sicherer als in vielen anderen Ländern.

Die Kraftwerke sind sicher gegen Flugzeugabstrurz, Terrorismus und Sabotage usw.. Die Vorschriften sehen dies so vor. Vielleicht stimmt dies

sogar. Aber: Sind sie auch sicher gegen menschliches Versagen, gegen stinknormale Schlamperei, den ganz alltäglichen Schlendrian, der irgendwann

überall Einzug hält und in Tschernobyl eingezogen war. Sind die Kraftwerke sicher gegen banale technische Störungen, die irgendwann immer eintreten können? Und was irgendwann eintreten kann,

wird auch mit Sicherheit eintreten. Irgendwann und irgendwo. Das beweist die jüngere Geschichte. Und "irgendwo" kann durchaus heißen "hier bei uns

", auch wenn ein Reaktorunfall selbst (oder Vergleichbares) in einem unserer Nachbarländer - es gibt eine ganze Menge davon - passiert.

Es wäre unfair, dem Herrn v. Weizsäcker bestimmte damalige Fehleischätzungen vorzuwerfen, wenngleich Fehleinschätzungen dieser Art vieler

Wissenschaftler möglicherweise zu dem Zustand der Energiegewinnung geführt haben, wie wir ihn jetzt vorfinden.

Es wäre aber unklug, aus Fehlern der Vergangenheit nicht zu lernen!

Hier spiele ich auf die "neueste Mode des wissenschaftlich-technischen Fortschrittes" an: Die Genforschung und Gentechnologie.

Der Aus

-Stieg aus der Kernenergie ist äußerst schwer zu schaffen. Und ein einzelnes Land kann dies überhaupt nicht im Alleingang bewältigen. Es

sind im Laufe der letzten fünf Jahrzehnte weltweit Tatsachen geschaffen worden, die sich nicht mehr, oder nur langfristig, rückgängig machen lassen.

Doch beim Ein-Stieg in die Gentechnologie sollte man äußerste Vorsicht walten lassen. Und all denjenigen, die “ganz genau nachweisen”, dass es

praktisch keine Gefahren geben kann, sollte man - kein Wort glauben.

13.04.2001

Glaubt man kompetenten Fachleuten, so ist der Ausstieg aus der Kernenergie weder sinnvoll noch überhaupt realisierbar.

Die Problematik der Kernenergie scheint ein recht unbequemes und widerborstiges Thema zu sein. Hatte ich mich im Artikel Kernenergie vorrangig

mit den Aspekten der Sicherheit befasst und dabei auch auf gewisse Fehleinschätzungen hochrangiger Physiker in der Vergangenheit hingewiesen, so

geht es im jetzigen Beitrag um die "Unverzichtbarkeit" der Atomkraftwerke - in Deutschland und überhaupt.

Ein Argument für die Kernenergie - natürlich auch von den Vertretern der Stromkonzerne vorgebracht - ist deren Umweltverträglichkeit. Weder Kohlendioxid - als Treibhausgas

diskreditiert (auch das wäre ein interessantes Thema) - noch die anderen Oxidationsprodukte, die bei der

Verbrennung fossiler Rohstoffe (Kohle, Öl, Gas) nun einmal entstehen, fallen hierbei an. Und so lange nichts Schlimmes passiert, kann man dieser

Argumentation durchaus positive Seiten abgewinnen. Da aber bereits mehrfach "Schlimmes passiert" ist, gibt es leider andere Argumentations-Schwerpunkte, weil die

ganz spezifischen Risiken der Kernenergie in das Kalkül einbezogen werden müssen.

Eine weiteres Argument beruft sich darauf, dass es derzeit keine sinnvolle und praktikable Alternative zu den Wärmekraftwerken gibt, welche in

der Lage wäre, die nach dem Ausstieg aus der Kernenergie klaffende Lücke zu schließen. Zunächst haben wir es damit zu tun, dass der Großteil

aller Elektroenergie eben aus Wärmekraftwerken stammt. Dabei ist es physikalisch unerheblich, ob diese Wärme durch Verbrennung fossiler

Energieträger gewonnen wird (mit den bekannten chemischen Nebenwirkungen) oder durch Spaltung schwerer Atomkerne (mit den bekannten

physikalischen Nebenwirkungen). Und bei der Nutzung der Fusion leichter Kerne, mit noch wesentlich höherer Energieausbeute als bei der

Kernspaltung, ist man in den letzten vier Jahrzehnten nicht wirklich einen Schritt weiter gekommen.

Man sollte jedoch folgendes bedenken: In jedem Fall erzeugt man - wie auch immer - Wärme. Der dabei erhitzte Dampf wandelt die thermische

Energie mit Hilfe von Turbinen in mechanische (Rotations-)Energie um. Und der an die Turbine gekoppelte Generator ist schließlich für die

Erzeugung der Elektroenergie zuständig, die ihrerseits über ein gigantisches nationales und transnationales Verteilernetz (Überlandleitungen, Erdkabel

, Umformerstationen und was es sonst noch gibt.) irgendwie - mit nicht unerheblichen Verlusten allerdings - den Endverbraucher, die Industrie oder den Privatnutzer, erreicht.

Im Klartext: Im Prinzip arbeiten wir immer noch mit den technischen Konzepten des ausgehenden 19. und beginnenden 20. Jahrhunderts (vgl. Tradition und Fortschritt). Gewiss, die Dampfmaschine wurde irgendwann durch die Dampfturbine ersetzt, und auch sonst gab es zahlreiche

technische Neuerungen, die für eine erhebliche Verbesserung des Wirkungsgrades sorgten. Auch Gasturbinen haben in mobilen Systemen (z.B. auf

Schiffen) durchaus Bedeutung erlangen können. Aber: Der unrentable Umweg über die Wärmeenergie ist geblieben, mit dem Nebeneffekt, dass die

letztendlich verwertbare Nutzenergie beim Kunden nur einen Bruchteil der erzeugten Primärenergie ausmacht. Hier gibt es bezüglich des maximalen

Wirkungsgrades physikalische und technische Grenzen, die grundsätzlich unüberschreitbar sind. Ein großer Teil der erzeugten Wärme heizt "sinnvoll und umweltfreundlich" in Form der Abwärme

(s. Energie-Info - Kühlturm) die Umgebung auf. Hierzu ein Zitat (Kraft-Wärme-Kopplung):

Bei der Stromerzeugung wird in Deutschland insgesamt ca. 60% der eingesetzten Energie in Form von Wärme ungenutzt weggeworfen.

Diese Wärmeenergie würde für den gesamten Heizbedarf in Deutschland ausreichen. Eine Nutzung dieser Abwärme ist in

Großkraftwerken nur begrenzt wirtschaftlich, da sie häufig weit außerhalb der Orte stehen, wo diese benötigt wird. Genau hier setzt die

dezentrale Kraft-Wärme-Kopplung ein. Als kleine, kompakte Energieversorgungsaggregate können Klein-BHKW dort untergebracht werden, wo die Abwärme auch genutzt wird.

Noch ein anderes Zitat (https://www.bdew.de):

Naturgesetzlich fällt mindestens die Hälfte der mit Kernbrennstoff, Kohle oder Öl bereitgestellten Energie als Wärme mit niedriger

Temperatur an, die nicht mehr zur Stromerzeugung geeignet ist. Die Abwärme wird vom Kühlwasser aufgenommen. Im Kühlturm wird

das Wasser dann abgekühlt und fließt anschließend entweder zurück in den Fluß, dem es entnommen wurde, oder wird erneut in den

Kühlkreislauf der Anlage eingespeist. Nur Kraftwerke an Flüssen, die auch im Hochsommer genügend Wasser führen, so daß die

Temperatur nicht übermäßig ansteigt, dürfen das gereinigte Kühlwasser stets direkt in den Fluß leiten.

"Naturgesetzlich" ist diese Angelegenheit insofern nur, als dass - wie bereits bemerkt - die Art und Weise der Energiegewinnung (Wärme) und

-verteilung (weil zentrale Erzeugung) zu diesen widersinnigen Effekten führt.

Ob Kohle- oder Kernkraftwerk: Der weitaus größte Energieanteil wird dazu "genutzt", die Umwelt aufzuheizen!

Das Ergebnis: Anstatt dafür zu sorgen, dass einmal gewonnene Energie möglichst effektiv verwertet wird, sucht man das Heil in der Erzeugung

immer größerer Energiemengen. In diesem Sinne sind Kernkraftwerke unverzichtbar, da die fossilen Energieträger irgendwann nicht

mehr zur Verfügung stehen werden. Konsequenterweise müsste man - wollte man all den Argumenten folgen - eines Tages (fast) sämtliche Energie

aus Kernkraftwerken gewinnen. Hier erweist sich - unabhängig von bekannten Alternativen (z.B. erneuerbaren Energien) und noch unbekannten

Ausweichmöglichkeiten - der bisher beschrittene Weg von Wissenschaft und Technik langfristig als Sackgasse. Ob die erneuerbaren Energien mit ihren

bisherigen technischen Lösungen bzw. Lösungsansätzen eines Tages wirklich die etablierten Formen der Energieerzeugung substituieren

können, vermag ich nicht abschließend zu beurteilen. Meiner Überzeugung nach sind derzeit keine wirklich allgemein einsetzbare Alternativen zu den

bisherigen thermischen Großkraftwerken gefunden worden. Es gibt wohl nur Spezial-Lösungen für spezielle Zwecke. Und wenn man bedenkt, dass

in den letzten 50 Jahren (etwa) gigantische Aufwendungen in der Forschung nicht wirklich geholfen haben, das Energieproblem zu lösen, sollte man

durchaus skeptisch reagieren. [Auch im Jahr 2018 gibt es eine Menge unbeantworteter Fragen. Ein Problem z. B. wäre das der effizienten Energiespeicherung.]

Hier zeigt sich erneut (vgl. Tradition und Fortschritt), dass man einmal beschrittene Wege nicht verlassen kann - oder nicht verlassen will. Der

Verlauf der Entwicklung von Wissenschaft und Technik, mit all den sozialen Implikationen und den nach und nach errichteten technischen

Infrastrukuren, hat Tatsachen geschaffen, die - erstens - nicht vorhersehbar waren und die - zweitens - so gut wie irreversibel sind.

Die Energiegewinnung ist ein physikalisches Problem. Und hier beschreitet die Wissenschaft - sowohl die Grundlagenforschung als auch die

anwendungsorientierte Forschung - genau abgesteckte Wege. Der Fusionsreaktor soll - das glaubt man tatsächlich immer noch - das Energieproblem künftig lösen können.

In 40 Jahren - vielleicht.

Nun erinnere ich mich persönlich sogar daran, dass es eine vergleichbare Prognose schon einmal gegeben hatte: vor 40 Jahren - ungefähr!

- Ist es nun entscheidbar, ob eine wissenschaftlich-technische Zielstellung überhaupt realisierbar ist oder auch nicht?

- Wenn ja, wer kann - und will - das entscheiden?

- Welche Konsequenzen hätten solche Entscheidungen?

- Wann gibt man "Sackgassen-Forschungen" (endlich) auf?

- Gibt es überhaupt tragfähige und praktikable Alternativen?

- Welche alternativen Zielstellungen sind möglicherweise - und zwar unabhängig vom gegebenen wissenschaftlichen Erkenntnisstand - formulierbar? - (Beispiel: Eine solche Zielstellung

- nicht Lösungsansatz, den kann es nicht geben! - könnte lauten: Allgemein einsetzbare

dezentrale Energiequelle ohne den Umweg über die Wärmeenergie und ohne Einsatz fossiler Brennstoffe. Ein solches Ziel ist zurzeit physikalisch nicht einmal denkbar

.) [Nun gut, es gibt, ca. 17 Jahre nachdem dieser Text entstand lokale autarke Lösungen mit Solarelementen, die aber noch nicht allgemein eingesetzt werden (können?).]

Unbeantwortbare Fragen - so scheint es. Unbeantwortbar sind diese Fragen auf alle Fälle vom Fachwissenschaftler, der sich mit ganz speziellen

Problemen auf ganz spezielle Weise mit ganz spezieller Zielstellung befasst.

Nachbemerkungen: Erst beim Schreiben dieser Zeilen wird mir wirklich bewusst, dass die Erzeugung von Wärme mit Elektroenergie ziemlich

idiotisch ist. Da werden irgendwo gigantische Mengen an Wärmeenergie erzeugt, mit niedrigem Wirkungsgrad in Elektroenergie umgewandelt, schließlich mit

gewaltigem Aufwand, aber verlustbehaftet, über weite Entfernungen transportiert. Und endlich koche ich - und Millionen andere Leute

können ebenfalls nicht anders - auf dem Elektroherd das Mittagessen. Da kann man nichts machen, es sei denn, man zieht in eine

Wohnung mit (Erd-)Gasanschluss. Das Gas hat zwar auch einen weiten Weg zurück gelegt, aber immerhin erzeuge und verwerte ich die Wärmeenergie in einem

Arbeitsgang. (Ob der "Wirkungsgrad über alles" hierbei besser ist, kann ich momentan nicht einschätzen.)

08.08.2001

Es gibt alte physikalische und chemische Wirkprinzipien. Nicht alle finden eine schnelle technische Realisierung.

Ein Engländer namens William Robert Grove (1811-1896) fand 1839 ein Wirkprinzip, welches es ermöglichte, durch Oxidation von Wasserstoff auf direktem

Wege - ohne den Umweg über die thermische und mechanische Energie - Elektroenergie zu erzeugen. Diese

Brennstoffzelle wandelte chemische Energie, ähnlich wie bei einem galvanischen Element, in Elektroenergie um. Und das mit einem beachtlichem Wirkungsgrad.

Die bisher übliche und bedeutendste Variante der Erzeugung von Elektroenergie ist allgemein bekannt. Alle thermischen Kraftwerke liefern den

Strom auf die gleiche Weise, wobei es unerheblich ist, ob die Wärme durch Verbrennung fossiler Energieträger (Kohle, Öl oder Gas) erzeugt wird

oder durch den Einsatz nuklearer Reaktoren (siehe auch Kernenergie(II)).

Alternative Formen der Energiegewinnung - sehen wir einmal von den Wasserkraftwerken ab - konnten bislang nie eine überragende Bedeutung

gewinnen. Erst mit dem "Ölkrise-Schock" Anfang der siebziger Jahre des 20. Jahrhunderts vollzog sich teils ein Bewusstseinswandel. Erstens hatte

man sich abhängig gemacht von den Öl-Lieferanten und zweitens - dies kam hinzu - reifte die Erkenntnis von der grundsätzlichen Begrenztheit der

natürlichen Ressourcen. Hinzu kam der immer mehr um sich greifende Umweltschutz-Gedanke: Die Verbrennung fossiler Rohstoffe setzt immerhin

eine Reihe von Stoffen frei, die - so glaubt(e) man zu wissen - nicht besonders umweltfreundlich sind. Alles nichts Neues.

Da aber als geradezu unerschöpfliche Energiequelle die Kernenergie zur Verfügung stand, schien der Ausweg aus der Misere nur eine Frage der Zeit

zu sein. Die Kernspaltung beherrschte man bereits in der Mitte des 20. Jahrhunderts (davon war man überzeugt); und die Kernfusion als die

"engültige Lösung des Energieproblems" sollte spätestens zur Jahrtausendwende uns aller Energiesorgen entledigen.

Nun wissen wir, dass die Entwicklung doch ein ganz klein wenig anders verlief. Alte Anschauungen erfuhren eine gewisse Relativierung. Und auch in

der Forschung wurden einige andere Akzente gesetzt. An der Kernfusion arbeitet man zwar immer noch, doch andere Themen, über Jahrzehnte ein

Schattendasein fristend, scheinen an Bedeutung zu gewinnen. Zu diesen Dingen zählt die Problematik der Brennstoffzelle. Seit einigen Jahren arbeitet

man intensiv an den verschiedenen technischen Lösungen. Man ist fast geneigt, diese Angelegenheit für eine Modeerscheinung zu halten. Doch glaube ich, dass mehr dahinter steckt. Im Beitrag Kernenergie (II) formulierte ich folgende Sätze:

Welche alternativen Zielstellungen sind möglicherweise - und zwar unabhängig vom gegebenen wissenschaftlichen Erkenntnisstand -

formulierbar? - (Beispiel: Eine solche Zielstellung - nicht Lösungsansatz, den kann es nicht geben! - könnte lauten: Allgemein einsetzbare

dezentrale Energiequelle ohne den Umweg über die Wärmeenergie und ohne Einsatz fossiler Brennstoffe. Ein solches Ziel ist zurzeit physikalisch nicht einmal denkbar.)

Im jetzigen Zusammenhang scheinen diese Sätze doch nicht völlig der Wahrheit zu entsprechen. Doch man bedenke, zunächst benötigt man

Wasserstoff. Dieser muss elektrolytisch aus Wasser gewonnen werden. Dazu braucht man Strom, den man beispielsweise aus Sonnenenergie oder

anderen erneuerbaren Energien gewinnen kann (oder muss, sonst hat man ja nichts gekonnt). Damit haben wir Wasserstoff als Energieträger

gewonnen - auf Basis von Sonnenen- oder Windenergie. Recht aufwendig, aber nicht utopisch. Die Alternative wäre es, den Wasserstoff durch

Kohlenwasserstoffe (Grundlage Erdgas) zu substituieren. Damit haben wir aber unser altes Problem, uns von fossilen Energieträgern unabhängig zu

machen, wieder auf dem Hals. Und Biogas kann wohl auch nicht die alleinige Lösung sein.

Wie auch immer, interessant ist es allemal, wie altbekannte elektrochemische Wirkprinzipien nach etwa eineinhalb Jahrhunderten auf ihre

"Massentauglichkeit" überprüft werden. Noch zu Beginn der "Raumfahrt-Ära" waren Brennstoffzellen etwas Exklusives, weil viel zu teuer und für die

Massenproduktion ungeeignet. Wie es scheint, ist der gesellschaftliche Druck mittlerweile groß genug geworden, sich von Einseitigkeiten in der

Forschung zu trennen. Man darf gespannt sein, wie die Entwicklung weiter voranschreiten wird.

Nachtrag 2018: Mittlerweile gibt es bereits Autos mit Brennstoffzelle. Als Beispiel das Brennstoffzellen-Auto von Toyota. Damit sind zwar noch

nicht alle Probleme gelöst. Aber immerhin ist dies bereits ein Anfang.

17.06.2001

Kaum ein Gebiet der Technik gibt soviel Anlass zum Staunen wie die Entwicklung der Computertechnik. Ein scheinbar grenzenloser

Fortschritt eröffnet gewaltige Perspektiven. Oder?

"Unsere Zeit ist - so das allgemein anerkannte Vorurteil - eine sehr schnelllebige Zeit." Damit begann der Beitrag

Fortschritt und Stagnation. In diesem Kontext spielte ich unter anderem auf die Fortschritte der digitalen Rechentechnik an. An dieses Thema möchte ich in diesen Beitrag anknüpfen.

Mein erster Computer - es muss so um 1983 gewesen sein - war ein Sinclair ZX 81 . Standardmäßig war das Gerät mit einem Speicher von "sagenhaften" 1 KB ausgerüstet. Ein Z80-Prozessor versah seinen Dienst und kümmerte sich neben seiner Hauptaufgabe auch

noch um den Bildschirm (über einen UHF-Modulator betriebenen Fernseher). Und das alles im Rahmen der Speicherkapazität von 1 KB! Natürlich gab es auch Speichererweiterungen

zu kaufen. 16 KB und - utopische - 64 KB, die dann aber auch stolze 600 DM kosteten. Und als "Massenspeicher" diente ein normales Kassettengerät. Mein erster Computer - es muss so um 1983 gewesen sein - war ein Sinclair ZX 81 . Standardmäßig war das Gerät mit einem Speicher von "sagenhaften" 1 KB ausgerüstet. Ein Z80-Prozessor versah seinen Dienst und kümmerte sich neben seiner Hauptaufgabe auch

noch um den Bildschirm (über einen UHF-Modulator betriebenen Fernseher). Und das alles im Rahmen der Speicherkapazität von 1 KB! Natürlich gab es auch Speichererweiterungen

zu kaufen. 16 KB und - utopische - 64 KB, die dann aber auch stolze 600 DM kosteten. Und als "Massenspeicher" diente ein normales Kassettengerät.

Wenige Monate später legte ich mir den berühmten "Brotkasten" zu. Der legendäre Commodore 64

begann gerade seinen einmaligen Siegeszug rund um die Welt anzutreten. Lang, lang ist's her. Immerhin gehörten “gewaltige” 64 KB Hauptspeicher (das entsprach dem

gesamten direkt vom Prozessor adressierbaren Speicherraum) und spezielle Bausteine für Grafik (Video Interface Controller mit 16 Farben und 320 x 200 Pixel Grafik - VIC) und Sound

(Sound Interface Device - SID) bereits zur Grundausstattung. Der Prozessor war eine mit 1 MHz (richtig gelesen: ein Megahertz) getaktete 8-Bit-CPU. Das Betriebssystem inklusive des

(bescheidenen) BASIC-Interpreters fanden Platz in 16 KB ROM. Hinzu kamen 4 KB ROM mit

dem Standard-Zeichensatz. Ein spezielles Kassettengerät ("Datasette") oder gar ein "intelligentes" (eigenes Betriebssystem) aber langsames 5.25"

Floppy-Laufwerk mit einer Speicherkapazität von immerhin 170 KB waren die möglichen externen Massenspeicher. Farbmonitor und (Nadel-

)Drucker - kein Problem. Die Kosten des Systems? Je nach Peripherie so etwa 2000 bis 2500 DM.

Der PC war auch schon langsam im Kommen. Der erste PC wurde von IBM angeboten, auf dem - unter anderem auch - das MS-DOS zum

Einsatz kam (PC 5110 mit 8088 Prozessor, 4.77 MHz, 64 KB RAM und 160 KB 5.25 Floppy). Für die erste WINDOWS-Version (1983)

fanden sich zunächst keine Interessenten. Bereits 1981 wurden weltweit immerhin knapp 1 Million PCs verkauft. Und die 5-MB-Festplatte von target="_blank"Apple kostete seinerzeit schlappe 3500 US-Dollar.

Was das Ganze soll? Nun, in dem von mir vorgestellten Zeitraum ist das Leistungsvermögen der Rechner - sagen wir einmal - etwa um den Faktor

1000 vervielfacht worden. Diese Zahl sollte man nicht zu eng sehen. Ein echter Vergleich ist kaum möglich, aber als qualitative Gegenüberstellung

durchaus nicht sinnlos. Außerdem habe ich die "richtigen" Computer - CRAY und artverwandte Maschinen - gar nicht erst berücksichtigt. Aber:

Was kann ein heutiger (Stand Sommer 2001) PC (256 MB Hauptspeicher, 40 GB Festplatte plus DVD-Laufwerk plus CD-Brenner, Grafik-Karte mit

einem hochentwickelten Grafik-Prozessor mit 64 MB RAM sowie Soundkarte) grundsätzlich mehr als der C64 seligen Angedenkens? Erst einmal

kann er das, was der "Steinzeit-Computer" auch schon konnte, nur viel vollkommener. Die typischen Anwendungen - Textverarbeitung,

Tabellenkalkulation, Datenbanken - gab es auch für den C64 schon - in dem engeren Rahmen seiner bescheideneren technischen Möglichkeiten

natürlich. Auch einige CAD-Anwendungen waren im Angebot. Nun ja, die grafische Auflösung und das Tempo ließen wirklich viele Wünsche offen.

Und der heutige Spiele-Freak würde sich angesichts der damaligen Grafik-Qualität ein überhebliches Grinsen kaum verkneifen können.

Was aber ist tatsächlich neu? Die wirkliche digitale Bild- und Tonverarbeitung fordert ein Mindestmaß an Prozessorleistung und Speicherkapazität.

Und dass ich heutzutage - in komprimierter Form als MP3-Dateien - locker den Inhalt von 1000 Musik-CDs (Größenordnung 60 GB) auf meinem

PC unterbringen kann, ist eine der Anwendungen, die wahrlich nicht vorhersehbar war. Und dann noch: Die weltweite Vernetzung der Rechner im

Internet bietet Möglichkeiten, die tatsächlich überwältigend sind. Nicht zu vergessen die Potenzen der Computer-Simulationen! Doch hier gelangen

selbst Supercomputer schnell an Grenzen ihrer Leistungsfähigkeit. Dies zeigt beispielsweise die Problematik der Wetter- und Klima-Modellierung.

Sind die heutigen Computer aber "intelligenter" geworden? Hier scheint es zunächst sinnvoll zu sein, auf den Begriff der Intelligenz etwas näher

einzugehen. Das soll im nächsten Beitrag andeutungsweise versucht werden. Aber wie sieht es mit so "schlichten" Nutzungsmöglichkeiten aus, wie es

die Sprachübersetzung darstellt? Testet man als "brauchbar" gekennzeichnete Übersetzungsprogramme, so sind die Ergebnisse - auch heute noch -

ziemlich ernüchternd. Elektronische Wörterbücher - kein Problem. Aber bereits das Übersetzen einfacher Texte liefert bisweilen recht erheiternde

Ergebnisse, bestenfalls als Rohübersetzungen geeignet und ohne Nachbearbeitung kaum verwertbar. So richtig "intelligent" sind die Programme wohl

immer noch nicht. [Das war damals 2001. Die bisherigen Fortschritte, bezogen auf das Jahr 2018, sind so gewaltig nicht.]

Eine kleine Kostprobe:

... is one of the most successful Internet Service Providers (ISP) in Europe. Our philosophy is to provide and constantly seek to improve

our range of excellent, value for money products and services, backed up by first class, friendly customer services and support. The fact

that the majority of our customers come from personal recommendation and word of mouth, is testimony to these core beliefs.

Die Übersetzung liest sich ziemlich unterhaltsam:

... ist eins von dem meisten erfolgreichen Internetdienst Versorgern (ISP) in Europa. Unsere Philosophie ist zu liefern und stetig suche zu

verbessern unser Bereich von ausgezeichnet, Wert für Geld Produkte und Dienste, gesichert durch erste Klasse, freundlichen Kunden

Dienste und Unterstützung. Die Tatsache die die Mehrheit von unseren Kunden kommen von Persönliche Empfehlung und Wort von Mund, ist Zeugnis zu diesen Kern glauben.

Zugegeben, eine Übersetzung neueren Datums (2018) mit dem Google-Übersetzer sieht schon ein wenig besser aus:

... ist einer der erfolgreichsten Internet Service Provider (ISP) in Europa. Unsere Philosophie ist es, unser Angebot an exzellenten,

preiswerten Produkten und Dienstleistungen zu verbessern und zu verbessern, unterstützt durch erstklassigen, freundlichen Kundenservice

und Support. Die Tatsache, dass die Mehrheit unserer Kunden aus persönlicher Empfehlung und aus Mundpropaganda kommt, ist ein Zeugnis für diese Kernüberzeugungen.

Und die Spracherkennung? Die flüssige Unterhaltung mit dem Computer in Umgangssprache bleibt nach wie vor noch Zukunftsmusik. Und ist das

wirklich erstrebenswert? Da funktioniert das "Lesen" gedruckter Texte (OCR-Programme - optical character recognition) schon weitaus besser.

Aber bei der Bilderkennung sind die bisher erzielten Ergebnisse auch in heutiger Zeit nicht gerade überwältigend.

Doch was haben diese technischen Reminiszenzen mit den Wissenschaften zu tun? Im nächsten Beitrag kommen wir der Angelegenheit einen Schritt näher.

21.06.2001

Fehleinschätzungen in der Vergangenheit und Neuorientierung in der Gegenwart - dies kennzeichnet unter anderem unser Verständnis von

den Computern und Robotern.

SPIEGEL-ONLINE brachte Anfang des Jahres 2001 eine höchst interessante Serie über erfüllte und

unerfüllte Visionen. SPIEGEL-ONLINE brachte Anfang des Jahres 2001 eine höchst interessante Serie über erfüllte und

unerfüllte Visionen.

Teil 4 dieser Serie - Spielmacher der Zukunft - befasste sich mit folgendem Thema:

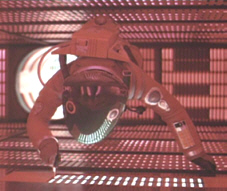

Wie lange bleibt ein Computer wie Kubricks. HAL 9000 [Das Bild zeigt eine Szene aus dem Film 2001:

Odyssee im Weltraum - Dave beim Abschalten seines "Widersachers" HAL.] noch Science-Fiction? Ein

Gespräch mit dem Informatiker Bernhard Nebel über Künstliche Intelligenz und Fußballroboter.

Hier einige Antworten des Informatik-Professors Bernhard Nebel von der Uni Freiburg im Rahmen des genannten Interviews:

Als ich studierte, standen Expertensysteme im Mittelpunkt. Heute geht es mehr in Richtung autonomer Agenten, worunter sowohl

Software-Agenten in Datennetzen als auch Roboter fallen. Durchgängig war und ist das Motiv der KI, intelligente, selbständig agierende Maschinen zu bauen. ...

Vor 20 bis 30 Jahren wurde Intelligenz noch sehr kopfbetont gesehen. Das war eine Art autistischer Intelligenz, bei der es darum ging, tief

nachzudenken Heute sehen wir die Intelligenz eher in der Interaktion eines Systems mit der Umwelt. ...

Wer sich mit Bildverarbeitung beschäftigt, weiß, wie viel Intelligenz darin steckt. Das gilt besonders für die Prozesse, mit denen wir

Bildinhalte interpretieren. Auf einer niedrigen Ebene geht es darum, zum Beispiel Kanten zu erkennen. Aber irgendwann soll der Computer

auch zwischen einem Auto und einem Schreibtisch unterscheiden können. Das ist extrem schwierig. ...

Im folgenden Text geht es um Fußballroboter und Roboterfußball sowie eine Fußball-WM für Roboter (siehe auch Uni Freiburg - Institut für

Informatik - RoboCup'2000 world champion):

Letztes Jahr hatten wir damit extreme Probleme. Bei der Abreise zur WM funktionierte gar nichts, obwohl das Team einen ganzen Monat

Tag und Nacht durchgearbeitet hatte. Unsere Roboter sind mittlerweile einfach zu alt und dadurch unzuverlässig. ...

Im Moment wissen wir bei vielen Dingen noch nicht, wie wir sie überhaupt nachbilden können. Wenn sie zum Beispiel kleine Kinder

beobachten, können sie sehen, wie begeistert sie sind, etwas über die Welt zu lernen. Einem Computer so etwas beizubringen, ist zur Zeit noch völlig unmöglich.

Die Schwerpunkte - wer hätte das früher gedacht - haben sich offensichtlich verschoben. Und dass man seit Jahren versucht, Fußball spielende

Roboter zu bauen, erscheint auf den ersten Blick schon etwas seltsam. Wie auch immer, als gleichwertige Akteure in einer richtigen Mannschaft wird

man solche Spieler noch lange vergeblich suchen müssen.

In einem noch älteren Beitrag von SPIEGEL-ONLINE (Falsche Propheten - Die absurdesten Fehlprognosen der Zukunftsforscher vom 03.04

.2000.) finden wir folgende ziemlich aufschlussreiche Aussagen (Vielleicht zählt man eines Tages die Klimakatastrophe auch zu den "absurdesten

Fehlprognosen"):

Der Blick auf das neue Jahrtausend, den Zukunftsforscher der 1960er Jahre wagten, fiel kaum treffender aus.

Zwar waren es überwiegend Seher mit akademischen Graden, die sich einer Wortschöpfung des Berliner Politologen Ossip K. Flechtheim

folgend nun "Futurologen" nannten; aber die Fehlerquote ihrer Voraussagen lag, wie gehabt, bei 80 Prozent, wie eine US-Studie jüngst ergab. ...

Computer mit einem IQ von "mehr als 150 Punkten" wurden von der Mehrheit der befragten Wissenschaftler für 1990 vorhergesehen, der

perfekte Übersetzungscomputer ("mit korrekter Grammatik") sogar schon für 1977. Den mysteriös blinkenden Riesencomputern dichteten die Futurologen durchweg märchenhafte Fähigkeiten an.

Offensichtlich begann man mit den Fehleinschätzungen bereits zu jener Zeit, als die "Elektronengehirne" in das Rampenlicht des öffentlichen

Interesses rückten. Doch sah man viele Dinge - auch anno 1964 schon - teilweise durchaus realistisch. An dieser Stelle nochmals eine Textpassage aus dem im Beitrag Der achte Tag der Schöpfung bereits zitierten Buch gleichen Titels:

Die Elektronischen Maschinen, von den Amerikanern zuerst electronic brains - Elektronengehirne - genannt, sind

der Welt als legitime Nachfahren der phantastischen Roboter vorgestellt worden. Es ist verständlich, daß Fachleute

bis heute bemüht sind, die Legendenbildung um diese neue Art von Maschinen zu unterdrücken. Die Elektronischen Maschinen, von den Amerikanern zuerst electronic brains - Elektronengehirne - genannt, sind

der Welt als legitime Nachfahren der phantastischen Roboter vorgestellt worden. Es ist verständlich, daß Fachleute

bis heute bemüht sind, die Legendenbildung um diese neue Art von Maschinen zu unterdrücken.

"Man sollte endlich davon absehen, solchen Unsinn in die Gehirne der Menschen zu verpflanzen", empörte sich

1950 der deutsche Ingenieur und Publizist Erich Laßwitz. Zu jener Zeit war aber die Diskussion über das

Denkvermögen in vollem Gange. Nicht Phantasten und Schwärmer hatten die Frage aufgegriffen, sondern die Begründer der Kybernetik selbst. In den Veröffentlichungen Norbert Wieners [Foto links] klingt sie immer wieder an. Auch der überragende Princeton-Mathematiker John von Neumann [Foto rechts] stellte sie. ...

Das menschliche Gehirn ist - darüber gibt es keinen Zweifel - das differenzierteste und wertvollste Organ, das die Natur je hervorbrachte. Es wäre nicht nur überheblich, sondern

auch sachlich falsch, den Computer als Elektronengehirn zu bezeichnen. Er ist nicht dem biologischen Denkapparat nachgebaut worden, denn bis heute weiß noch niemand, wie

das menschliche Gehirn denkt.

Diese Aussagen sind aktuell geblieben, “denn bis heute”, wir sprechen jetzt aber vom Jahr 2001, “weiß” immer “noch

niemand, wie das menschliche Gehirn denkt”. Hier noch weitere beachtenswerte Sätze aus jenem Buch:

Die Untersuchung der Gehirnströme im Elektroenzephalogramm ist bisher immer enttäuschend verlaufen. Das

Bild der Hirnströme zeigt keine erheblichen Abweichungen, wenn ein Mensch vor sich hindöst oder wenn er

angestrengt nachdenkt. Das Schließen der Augen bringt viel mehr Bewegung in die Hirnstromkurven als eine intensive Beschäftigung mit

der Relativitätstheorie. Albert Einstein hat kurz vor seinem Tode seine Gehirnströme zur wissenschaftlichen Auswertung aufnehmen lassen. Sie unterschieden sich kaum von denen anderer Menschen.

Man kann davon ausgehen, dass sich an dieser Tatsache seit dem Zeitpunkt, an dem diese Zeilen geschrieben wurden kaum etwas Grundlegendes geändert hat (vgl. den Beitrag Frühjahrstagung 2001 der DPG).

Fortsetzung folgt: Cogito ergo sum - ich denke, also bin ich. Hier gelangen wir - zunächst - zur "natürlichen Intelligenz". Damit hätte man eigentlich anfangen

müssen.

01.07.2001

Ich denke, also bin ich. Ich bin mir meines Denkens bewusst und damit meiner eigenen Existenz.

Anknüpfend an die Beiträge Künstliche Intelligenz (I) und Künstliche Intelligenz (II) soll jetzt das Thema die "natürliche Intelligenz" sein.

Cogito ergo sum. Immerhin - so René Descartes (1596-1650, siehe Bild) - ist dies die erste und zunächst auch einzige

Gewissheit unseres Daseins in einer Welt des Zweifelns (Stichwort Solipsismus). Doch die weit reichenden philosophischen

Implikationen dieser Erkenntnis sollen uns erst einmal nicht interessieren. Das Denken an sich ist schon einmal des Nachdenkens

wert, auch wenn es ziemlich schwer fällt, den Begriff des Denkens und den des Bewusstseins exakt zu definieren. Auf alle Fälle ist eine Äußerung unseres

Bewusstseins die Fähigkeit, das Denken selbst zum Gegenstand des Denkens werden zu lassen. Cogito ergo sum. Immerhin - so René Descartes (1596-1650, siehe Bild) - ist dies die erste und zunächst auch einzige

Gewissheit unseres Daseins in einer Welt des Zweifelns (Stichwort Solipsismus). Doch die weit reichenden philosophischen

Implikationen dieser Erkenntnis sollen uns erst einmal nicht interessieren. Das Denken an sich ist schon einmal des Nachdenkens

wert, auch wenn es ziemlich schwer fällt, den Begriff des Denkens und den des Bewusstseins exakt zu definieren. Auf alle Fälle ist eine Äußerung unseres

Bewusstseins die Fähigkeit, das Denken selbst zum Gegenstand des Denkens werden zu lassen.

Wie auch immer man das menschliche Denken bewerten möge, so kann man durchaus davon ausgehen, dass die eben erwähnten

Reflexionen schon zu den "höheren" Manifestationen der Selbsterkenntnis zählen. Das Denken der Tiere bewegt sich auf einer mehr pragmatischen

Ebene; doch es scheinen die Vorstellungen überwunden zu sein, den Tieren jegliches Bewusstsein und jegliches Denken abzusprechen. Tiere waren

noch zu Beginn des 20. Jahrhunderts kaum mehr als - allerdings sehr hoch organisierte - "Reflex-Maschinen" (Stichwort Behaviorismus). Neuere Erkenntnisse, vielleicht in den letzten zwei bis drei Jahrzehnten gewonnen, legten die Gewissheit nahe, dass das Denken keine

qualitativ neue, nur uns allein zukommende Fähigkeit darstellt, sondern es sich um fließende Übergänge handelt.

Freilich, was das abstrakte begriffliche Denken betrifft, so gelangt eine Katze beispielsweise schnell an die Grenze ihrer Fähigkeiten. Dafür aber ist

die Katze uns, was das Klettern und das Mäuse Fangen betrifft, wahrhaft überlegen. Was aber hat das Fangen von Mäusen mit Intelligenz zu tun?

Anscheinend nichts. Es geht hier "nur" um bestimmte körperliche Fähigkeiten und Fertigkeiten, teilweise angeboren und zum anderen Teil erlernt.

Wenn es denn so einfach wäre! Gerade die Fortschritte der Verhaltensforschung und der Neurobiologie offenbaren uns die Abgründe bisheriger

(Fehl-)Einschätzungen. Das, was uns im alltäglichen Leben als scheinbar einfach gegenübertritt, ist von einer kaum überschaubaren Komplexität.

Nehmen wir - es macht sich ja recht gut - eine Katze, die auf Lauer liegt. Irgendwo im Gras hält sich eine, für uns nicht sichtbare, Beute versteckt.

Regungs- und geräuschlos sowie voller Aufmerksamkeit beobachtet die Katze das Geschehen. Und im richtigen Moment springt sie los - die arme Maus hat nicht die geringste Chance.

Dies beschreibt ganz elementare Vorgänge des alltäglichen Lebens - einer Katze zum Beispiel. Ein wichtige Einrichtung (nicht nur) der Wirbeltiere ist

der visuelle Kontakt mit der Außenwelt. Die physiologischen Zusammenhänge sind seit langem bekannt. Wie das Auge optisch funktioniert und wie

ein auf dem Kopf stehendes Bild auf der Retina entsteht, birgt wahrlich keine Rätsel. Die - bislang ungelösten - Rätsel finden wir auf der Ebene der

Bildverarbeitung und -erkennung. Hinzu kommt, dass andere Sinneseindrücke, vorrangig Gehör und Geruch, sich in den Prozess der Umwelt

-Wahrnehmung "einmischen". Wie kann eine Katze eine Maus eindeutig als Beute erkennen? Wie werden - die Grundlage dafür bildet das

binokulare Sehen - Entfernungen abgeschätzt? Wie funktioniert die Steuerung der körperlichen Aktivitäten (Ergreifen der Beute) auf Basis des gewonnenen “Bildes von der Welt”?

Erst im 19. Jahrhundert reifte die Erkenntnis, dass sich der weitaus größte Teil der gewaltigen Informationsverarbeitung und -verdichtung innerhalb des Zentralnervensystems auf

unbewusster Ebene abspielt. Und das, was wir bewusst wahrnehmen und erleben ist noch nicht einmal die berühmte

Spitze des Eisberges. Aber unsere höheren mentalen Fähigkeiten bauen auf jenen unbewussten Vorgängen auf, die in der Vergangenheit reichlich unterschätzt

wurden, wobei unsere bewussten geistigen Fähigkeiten in erstaunlicher Weise immer wieder Anlass gaben, sie zu überschätzen.

Diese Fehleinschätzungen lassen sich sogar in die Zeit zurück verfolgen, als die "Elektronenhirne" in Erscheinung traten.

Doch was können diese Maschinen wirklich? Hier ist es hilfreich, zu ergründen, worin unsere Fähigkeiten liegen. Nehmen wir eine einfache

Rechenaufgabe, beispielsweise 3 x 8. Das Ergebnis ist sofort bekannt: 24. Hier einen Taschenrechner zu bemühen, wäre Unfug. Aber folgende

komplexere Multiplikation ist im Allgemeinen nicht ohne Hilfsmittel zu bewältigen: 54321 x 126. Papier und Bleistift sind hier mindestens erforderlich,

und zusätzlich eine erlernte Vorschrift (einen Algorithmus), wie man diese “komplizierte Rechenaufgabe” zu lösen hat. Das lernt man bereits in der

Grundschule. Die Notwendigkeit, sich die einzelnen Zwischenergebnisse notieren zu müssen, liegt in der Begrenztheit unseres Kurzzeitgedächtnisses.

Nicht einmal die Aufgabe - acht simple Ziffern - kann man sich beim ersten Hinschauen merken. Ich habe diese Aufgabe als Test einmal nach dem

alten Verfahren gerechnet und dazu eine geschlagene Minute benötigt. Absolut peinlich jedoch: Es hatte sich ein Fehler eingeschlichen, wie die Kontrolle mit dem Taschenrechner ergab.

Die “Elektronenhirne” sind also besser als unsere eigenen. Jedenfalls, was formale (algorithmierbare) logische Entscheidungen betrifft und den

Umgang mit Zahlen angeht. Folgende - überspitzt formulierte - Folgerungen drängten sich dem naiven Beobachter vor Jahrzehnten auf: Wir können

Dinge, zu denen Tiere nicht fähig sind: Logisch denken und rechnen beispielsweise. Doch gelangen selbst wir - wir, die Krone der Schöpfung -

schnell an die Grenze jener Fähigkeiten. Nun aber hatte man Maschinen ersonnen und gebaut, die uns hierin derart überlegen sind, dass es kaum

möglich ist, diese Überlegenheit zu quantifizieren. Damit kam man - und dies spielte sich ja tatsächlich so ab - zu folgender Argumentation: Die Elektronik ist uns bislang auf einem

Gebiet geistiger Fähigkeiten haushoch überlegen; somit ist es nur eine Frage der Zeit und des unausweichlichen

technischen Fortschrittes, dass sich diese Überlegenheit auf weitere Felder - ebenso unausweichlich - ausdehnen muss.

Dass dem nicht so ist, wissen wir mittlerweile. Warum dies aber nicht anders sein kann, davon berichtet der nächste Beitrag.

Na ja: Man kann das Ganze auch umkehren und schlussfolgern: Die Maschinen sind uns in formalisierbaren (algorihmierbaren) “geistigen”

Angelegenheiten überlegen. Wenn dem so ist, dann jedoch ist es mit unserer Überlegenheit gegenüber dem Rest der Welt nicht weit her

Nachtrag 2018: Heutzutage verfolgt uns das Schlagwort “Künstliche Intelligenz” fast auf allen Wegen. Man tut fast so, als sei man schon ziemlich

weit gekommen. In Wahrheit jedoch hat sich seit dem Zeitpunkt des Schreibens obigen Textes bis heute nicht wirklich viel getan. Der technische

Fortschritt ist unbestritten, doch der künstlichen Intelligenz sind wir nicht wirklich einen Schritt näher gekommen.

15.07.2001

Das Schachspiel ist eine Herausforderung für den denkenden Menschen ganz allgemein - und für den Programmierer von

Schachprogrammen ganz besonders.

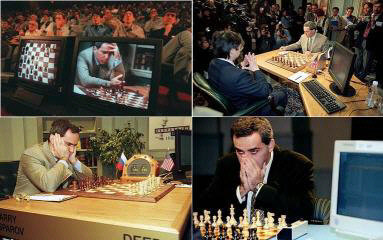

Eine geradezu niederschmetternde und deprimierende Niederlage erlitt "die

Menschheit" im Jahr 1997. Da war es doch tatsächlich dem IBM-Superrechner Deep Blue

gelungen, den damaligen Schachweltmeister Garri Kasparow zu schlagen. Und im Herbst diesen Jahres (2001) wird die nächste Runde Mensch gegen Maschine eingeläutet. Der jetzige Champion, der Russe Wladimir Kramnik, wird gegen Deep Fritz

antreten. Der elektronische Gegner des aktuellen Weltmeisters allerdings ist diesmal kein spezieller Superrechner, sondern die etwas aufgepeppte Version eines handelsüblichen Schachprogrammes

(Multiprozessor-Version des Programmes Fritz) einer Hamburger Schachprogramm-Schmiede. Man darf gespannt sein. Jedenfalls ist Deep Fritz ein

Programm, welches aus Niederlagen lernen kann und sich auf seinen Gegner einzustellen vermag. Eine geradezu niederschmetternde und deprimierende Niederlage erlitt "die

Menschheit" im Jahr 1997. Da war es doch tatsächlich dem IBM-Superrechner Deep Blue

gelungen, den damaligen Schachweltmeister Garri Kasparow zu schlagen. Und im Herbst diesen Jahres (2001) wird die nächste Runde Mensch gegen Maschine eingeläutet. Der jetzige Champion, der Russe Wladimir Kramnik, wird gegen Deep Fritz

antreten. Der elektronische Gegner des aktuellen Weltmeisters allerdings ist diesmal kein spezieller Superrechner, sondern die etwas aufgepeppte Version eines handelsüblichen Schachprogrammes

(Multiprozessor-Version des Programmes Fritz) einer Hamburger Schachprogramm-Schmiede. Man darf gespannt sein. Jedenfalls ist Deep Fritz ein

Programm, welches aus Niederlagen lernen kann und sich auf seinen Gegner einzustellen vermag.

Bereits in den Anfangsjahren der Rechentechnik gehörte es zu den

Herausforderungen der Programmierer, Programme zu entwickeln, die Schach spielen können. In all den Jahren hat man eine Menge Erfahrungen

gesammelt, was das Erarbeiten effizienter Algorithmen angeht. Und die Hardware gewann ebenfalls an Leistungsfähigkeit. Dabei ist die Spielweise

eines Großmeisters von der eines Schachprogrammes grundlegend verschieden ist.

Ein bemerkenswertes Detail im Rahmen der spektakulären Kämpfe Großmeister gegen Computer sollte nicht unerwähnt bleiben: Dem menschlichen

Schachspieler sitzt nicht etwa ein niedlicher Roboter, aus kleinen Kamera-Augen das Schachbrett musternd, gegenüber, der mit hydraulisch

gesteuerten Armen die Figuren bewegt, sondern - ein Mensch, der jene "niederen Hilfsfunktionen" übernehmen muss. Von solch "primitiver

Tätigkeit" entlastet, kann sich der Computer - respektive das Programm - vollkommen auf die Analyse des Spieles "konzentrieren". Als "Interface"

bedient man sich der Einfachheit halber eines Menschen. Selbst, wenn der Spieler in "direkten Kontakt" mit dem Computer tritt, so ist immerhin die

Tastatur zu bedienen und der Bildschirm zu beobachten. Das Schachprogramm hat von diesen "Nebensächlichkeiten" naturgemäß keine Ahnung.

Hierzu einige Aussagen des Informatik-Professors Bernhard Nebel von der Uni Freiburg im Rahmen eines Interviews (siehe auch Künstliche Intelligenz (II)):

Vor 20 bis 30 Jahren wurde Intelligenz noch sehr kopfbetont gesehen. Das war eine Art autistischer Intelligenz, bei der es darum ging, tief

nachzudenken Heute sehen wir die Intelligenz eher in der Interaktion eines Systems mit der Umwelt. ...

Wer sich mit Bildverarbeitung beschäftigt, weiß, wie viel Intelligenz darin steckt. Das gilt besonders für die Prozesse, mit denen wir

Bildinhalte interpretieren. ...Das ist extrem schwierig. ...

Sehen wir diese Sätze im Zusammenhang mit allen bisherigen Überlegungen, so müsste man sich eigentlich wundern. Einerseits hat man in der

Algorithmierung von (Spiel-)Strategien beachtliche Erfolge erzielt. Andererseits scheitert man immer noch an der Realisierung anscheinend

elementarer Prozesse. Denken wir uns einen fiktiven mobilen Schachroboter, der dem menschlichen Kontrahenten tatsächlich am Tisch gegenüber

sitzt und der zudem in der Lage ist, die Figuren auf dem Brett selbst zu erkennen und sie auch aktiv zu bewegen, so wären wir der "Künstlichen

Intelligenz" tatsächlich einen ganz kleinen - aber wirklich noch unbedeutenden - Schritt näher gekommen. Die jetzige Erfahrung jedoch zeigt, dass die

Bildanalyse weitaus schwieriger ist, als beispielsweise die abstrakte logische Analyse der Konstellation eines Schachspieles. Selbst wenn ein solcher

Roboter einmal funktionieren würde, wäre für die "Interaktion mit der Umwelt in Echtzeit" eine dermaßen hohe Rechenleistung erforderlich, dass das

eigentliche Schachspiel hierbei gewissermaßen nebenbei erledigt werden könnte, da es vergleichsweise bescheidene Computer-Ressourcen benötigt.

Wie auch immer irgendwelche Spiele "Mensch gegen Maschine" ausfallen werden: Der Sieger bleibt allemal der Mensch. Entweder der Schach

-Großmeister auf der einen Seite des Brettes oder das Entwickler-Team des Schachprogrammes (symbolisch) auf der anderen Seite! Gewiss, da

gibt es noch, als Bindeglied zwischen beiden, die bekannten Erzeugnisse der Mikroelektronik, welche die ebenso bekannten formal logische

"Hilfsfunktionen" übernehmen, deren Intelligenz aber lediglich die "transformierte Intelligenz" deren Schöpfer ist.

[Home] [Seitenanfang]

|